Nvidia, Pazartesi günü yaptığı açıklamada, H200 adı verilen yeni modelin, AI’i geliştirmek ve uygulamak için gereken büyük veri kümeleriyle daha iyi başa çıkmasını sağlayan yüksek bant genişlikli bellek veya HBM3e kullanma yeteneğine sahip olacağını söyledi. Amazon’un AWS’si, Alphabet’in Google Cloud’u ve Oracle’ın Bulut Altyapısı, gelecek yıldan itibaren yeni çipi kullanmayı taahhüt etti.

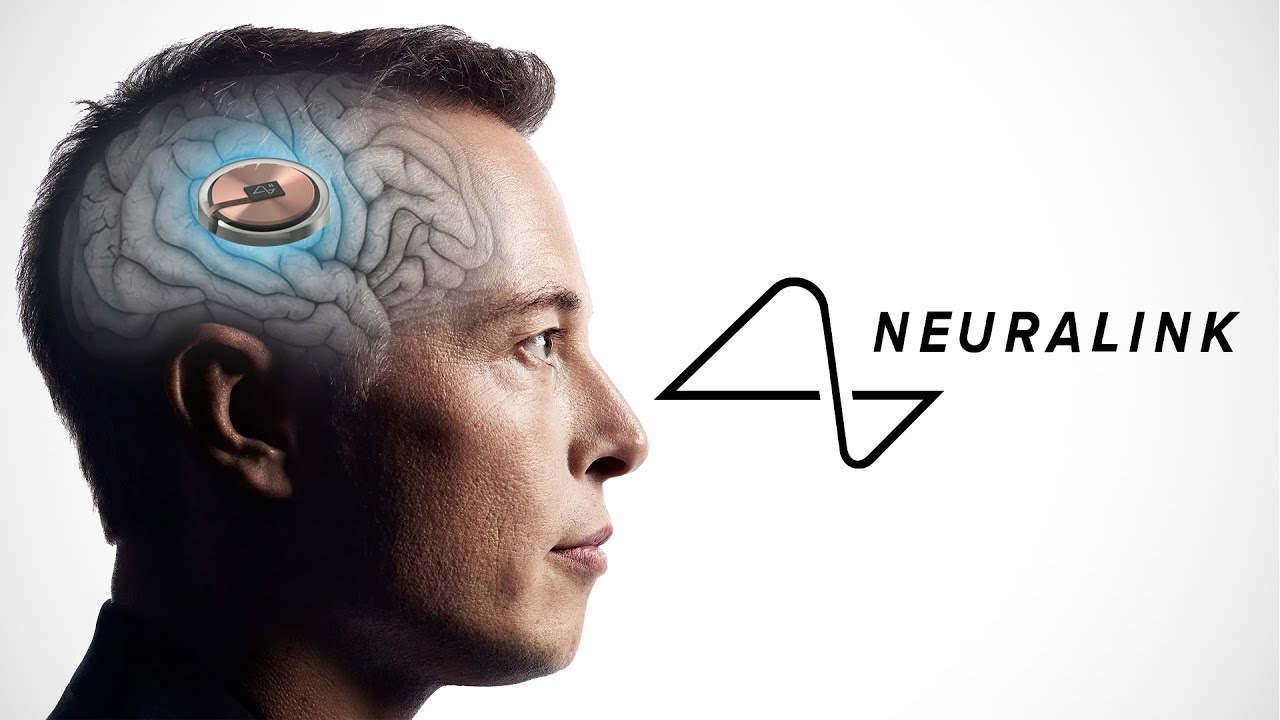

Yapay zeka hızlandırıcısı olarak bilinen Nvidia işlemcisinin mevcut sürümü zaten çok yüksek talep görüyor. Bu, çipi ele geçirme yetenekleriyle övünen Larry Ellison ve Elon Musk gibi teknoloji ağır topları arasında değerli bir meta. Ancak ürün daha fazla rekabetle karşı karşıya: AMD dördüncü çeyrekte rakip MI300 çipini pazara sunuyor ve Intel, Gaudi 2 modelinin H100’den daha hızlı olduğunu iddia ediyor.

Yeni ürünle Nvidia, AI modelleri ve hizmetleri oluşturmak için kullanılan veri setlerinin boyutuna ayak uydurmaya çalışıyor. Gelişmiş bellek kapasitesini eklemek, H200’ü verileri ve konuşmayı tanıma gibi görevleri yerine getirmek için AI’i eğiten bir işlem olan veri ile yazılımı bombalamada çok daha hızlı hale getirecek.

Yapay zekanın geliştirilmesi kısmına bu kadar odaklanan bir şirketin işin donanımsal mutfağına da bu kadar büyük çapta yatırım yapıyor olması şirketi bu sektör özelinde sarsılmaz bir konuma doğru götürüyor.

Teknoloji devinin bir sonraki hamlesinin ne olacağı ile ilgili henüz net bir açıklama yok fakat hakim görüş yapay zeka ağırlıklı ilerlemeye devam edeceği yönünde.