Araştırmacılar, özel yapım kötü niyetli modeller yükleyerek Hugging Face üzerinde çalışan Hizmet Olarak Yapay Zekâ sağlayıcılarını tehlikeye atabilecek güvenlik açıkları tespit ettiklerini duyurdu. Wiz Research firmasının analizi, araştırmacıların Hugging Face’e tahrif edilmiş modeller yükledikten sonra keyfi kod çalıştırabildiklerini ve bunu Hugging Face’in API özelliği içinde kullanarak, uç noktadaki cihzlarda yükseltilmiş kontrol elde edebildiklerini gösterdi.

Araştırmaya göre, saldırganlar bu güvenlik açıklarını başarılı bir şekilde kullanmaları halinde Hugging Face ortamı üzerinde “yıkıcı” bir etkiye sahip olabilir ve milyonlarca özel yapay zekâ modeline ve uygulamasına erişim sağlayabilirler. Endişe verici bir şekilde, Wiz bu bulguların tekil ve tesadüfi olduğuna inanmıyor ve araştırmacılar bunu bir hizmet endüstrisi olarak yapay zekâ için devam eden olası bir zorluk olarak belirtiyor.

Wiz araştırmacıları, “Bu bulguların Hugging Face’e özgü olmadığına ve bir hizmet şirketi olarak birçok YZ’nin karşılaşacağı zorlukları temsil ettiğine inanıyoruz” diyor ve ekliyor: “Güvenlik topluluğundaki bizler, bu hızlı (ve gerçekten inanılmaz) büyümeyi engellemeden güvenli altyapı ve korkulukların yerleştirilmesini sağlamak için bu şirketlerle yakın işbirliği içinde olmalıyız.”

Hugging Face güvenlik açığı nasıl çalışıyor?

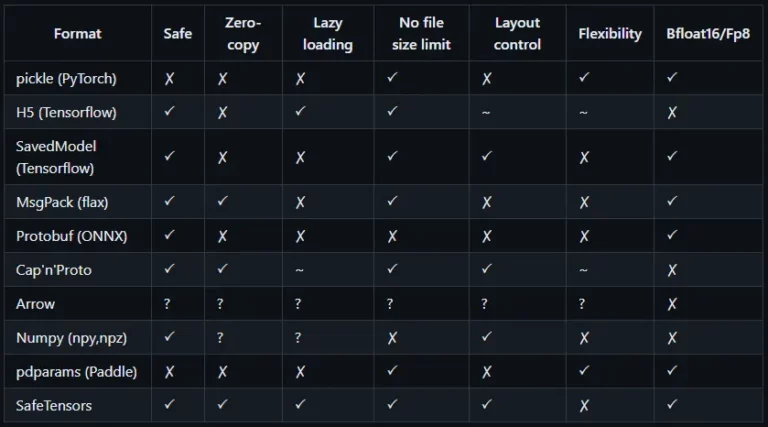

Wiz’in araştırması, Hugging Face ortamında bulunan ve teorik bir tehdit aktörünün yararlanabileceği iki kritik riski tanımlamalarına yol açtı. “Paylaşılan çıkarım altyapısının ele geçirilmesi” riski olarak adlandırılan ilk durumda araştırmacılar, belirli bir girdi için tahminler üretmek üzere eğitilmiş bir modelin kullanıldığı yapay zekâ çıkarım sürecinden yararlandılar. Wiz, çıkarım altyapısının genellikle “pickle” formatını kullanan “güvenilmeyen” modelleri çalıştırdığını tespit etti. “Pickle-serileştirilmiş” bir model, tehdit aktörüne gelişmiş ayrıcalıklar veya kullanıcılar arası erişim sağlayan bir uzaktan kod yürütme yükü içerebiliyor.

“Paylaşılan CI/CD devralma” riski olarak adlandırılan diğer saldırı biçiminde ise tehdit aktörleri bir tedarik zinciri saldırısı gerçekleştirmek için CI/CD hattının kontrolünü ele geçirmek amacıyla kötü amaçlı yapay zekâ uygulamaları derleyebilir ve yine ayrıcalıkların ve erişimin önünü açabilir. Saldırganlar ayrıca çeşitli yöntemlerle farklı bileşenleri hedef alabilir, örneğin “yanlış tahminler” oluşturmak için doğrudan girdiler yoluyla bir yapay zekâ modeline saldırabilir.

Wiz, güvenilmeyen YZ modellerinin bir uygulamaya belirgin güvenlik riskleri getirebileceğinden, geliştiricilerin ve mühendislerin modelleri indirirken yüksek bir dikkat duygusuyla çalışması gerektiğini belirtiyor.

Wiz Research tarafından önerilen bir diğer hafifletme yaklaşımı da podların IMDS’ye erişmesini ve küme içindeki bir düğümün rolünü almasını önlemek için IMDSv2’yi Hop Limit ile etkinleştirmek.

Wiz araştırmacıları, “Bu araştırma, güvenilmeyen yapay zekâ modellerinin (özellikle Pickle tabanlı olanların) kullanılmasının ciddi güvenlik sonuçlarına yol açabileceğini göstermektedir” diyor ve ekliyor: “Kuruluşlar, kullanılan tüm YZ yığınının görünürlüğüne ve yönetimine sahip olduklarından emin olmalı ve kötü niyetli modellerin kullanımı, eğitim verilerinin açığa çıkması, eğitimdeki hassas veriler, YZ SDK’larındaki güvenlik açıkları, YZ hizmetlerinin açığa çıkması ve saldırganlar tarafından istismar edilebilecek diğer toksik risk kombinasyonları dahil olmak üzere tüm riskleri dikkatlice analiz etmelidir.”