Ortaya çıkmasıyla beraber yapay zekâ dünyasında deprem yaratan ve bir anda liderliğe oturan DeepSeek yapay zeka sohbet robotu son zamanlarda en çok merak edilen konulardan biri. Yapay zekâ modelinin Çin menşeli olması, bazı kullanıcılarda kişisel veri güvenliği açısından endişe yaratıyor ve kullanmaya çekiniyorlar. Bir taraftan da, gördüğü büyük ilgi nedeniyle DeepSeek’in kapasitesini doldurmuş olması ve sık sık erişim hatası vermesi, kullanıcıların bu yeni yapay zekâ modelini denemelerini engelliyor.

DeepSeek’i yerel olarak çalıştırın

Açık kaynak kodlu bir yapay zekâ modeli olan DeepSeek’i bilgisayarınıza kurup çalıştırmak mükkün. Bu sayede yapay zekâya gönderdiğiniz mesajlar, yazdığınız promptlar sadece bilgisayarınızda kalıyor. Yurtdışındaki sunuculara gitmiyor. Yapay zekâ modeli de yerel olarak çalıştığından dolayı erişim kesintisi yaşanması gibi bir sorun da olmuyor. Tek sınır, bilgisayarınızın bilgi işlem gücü. Bilgisayarınız ne kadar güçlüyse, yüklediğiniz yapay zekâ modeli o kadar yüksek performanslı çalışıyor.

DeepSeek’i bilgisayarınıza yükleyin

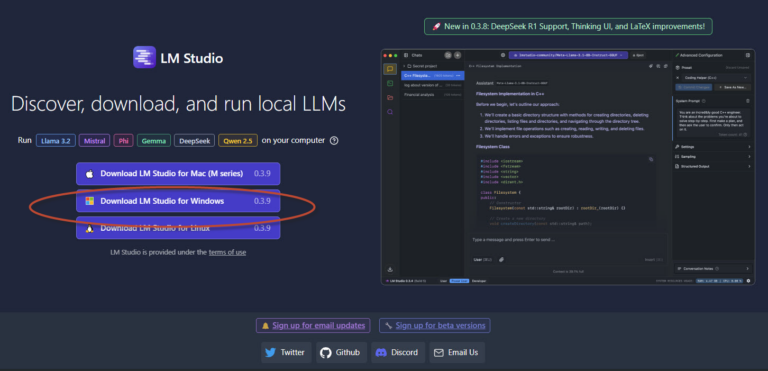

Bilgisayarınıza DeepSeek yüklemek için önce https://lmstudio.ai/ adresine gidip buradan LM Studio uygulamasını bilgisayarınıza indirmeniz gerekiyor.

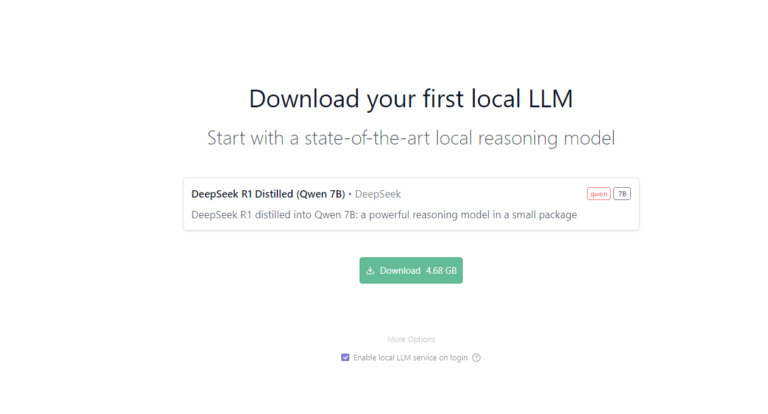

LM Studio uygulamasını indirip yükledikten sonra ilk çalıştırışta program hangi yapay zekâ modelini kullanmak istediğiniz soracak. Buradan DeepSeek, LLama veya başka yapay zekâ modellerini seçebilirsiniz. Bu yazının konusu DeepSeek yüklemek olduğu için, biz birinci seçenek olan DeepSeek R1 modelini seçiyoruz.

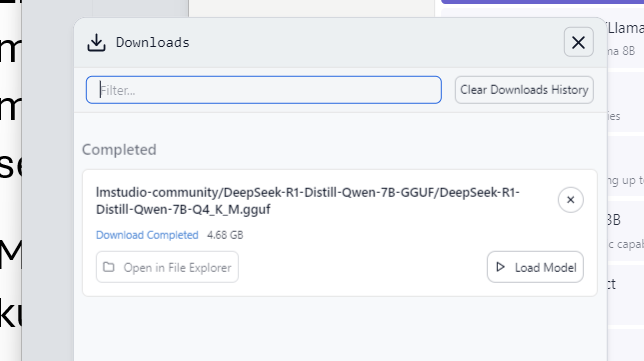

Modeli seçtikten sonra dosyanın indirilmesini bekliyoruz. LM Studio ilgili modeli indirip sisteme kuracak.

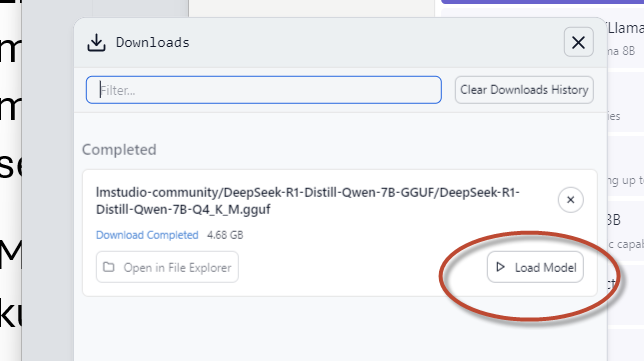

Kurulum tamamlandıktan sonra Load Model düğmesine basarak indirmiş olduğunuz yapay zekâ modelini yükleyin. Adım adım DeepSeek yüklemek

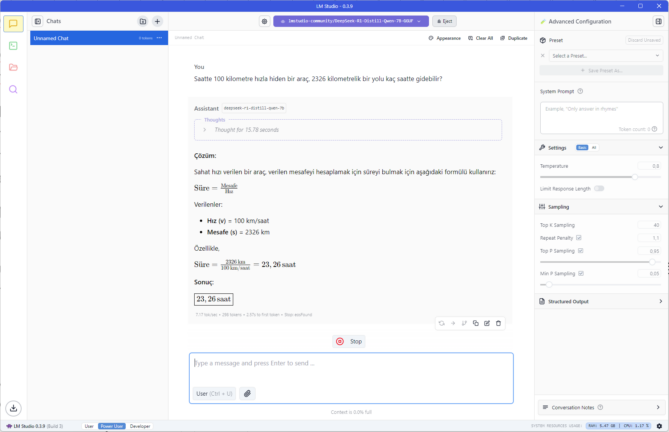

Artık LM Studio içerisinde yüklemiş olduğunuz yapay zekâ modelini kullanarak çalışmaya başlayabilirsiniz. Modelin performansı, daha önceden de belirttiğimiz gibi, bilgisayarınızın performansına bağlı olacaktır.

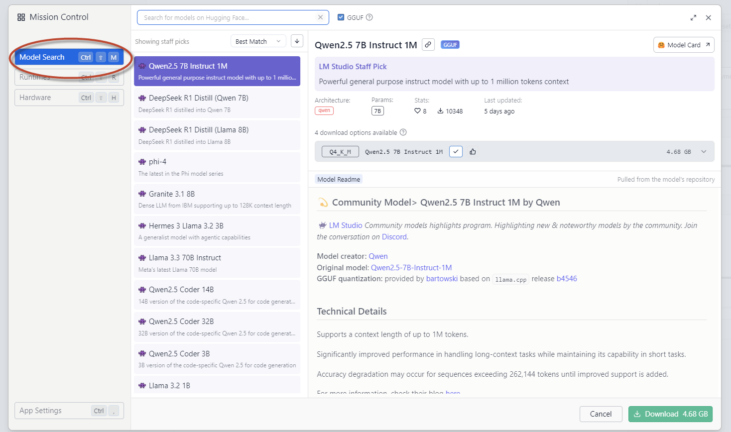

Farklı yapay zekâ modellerini yükleyin

LM Studio birden fazla yapay zekâ modelini destekliyor. Bu modelleri bilgisayarınıza indirip deneyebilirsiniz. Bunun için uygulamanın sağ altın bulunan ayarlar düğmesine basın, açılacak olan pencerede Model Search üzerine tıkladığınızda yükleyebileceğiniz farklı yapay zekâ modellerinin listesini görebilirsiniz.

Bu listeden istediğiniz modeli yükleyebilirsiniz. Yükleme tamamlandıktan sonra yüklediğiniz yapay zekâ modelini LM Studio uygulamasının üst bölümündeki model seçeneklerini kullanarak seçebilirsiniz.

Yapay Zeka modellerini yerel çalıştırmanın avantajları

- Gizlilik ve Veri Güvenliği AI modellerini yerel olarak çalıştırmak için en ikna edici nedenlerden biri artan gizliliktir. Bulut tabanlı bir hizmet kullandığınızda, verileriniz uzaktaki sunuculara gönderilir ve işlenir. Bu durum, veri ihlalleri ve yetkisiz erişim konusunda endişelere yol açar. Modelleri yerel olarak çalıştırarak, tüm hesaplamalar cihazınızda gerçekleşir ve hassas bilgiler hiçbir zaman kontrolünüzden çıkmaz.

- Azaltılmış Gecikme Süresi Bulut hizmetleri, verilerinizin bilgisayarınızdan uzak sunuculara gidip gelmesi nedeniyle gecikmeye yol açar. Sohbet botları, kod asistanları veya transkripsiyon araçları gibi gerçek zamanlı uygulamalarda bu gecikme, kullanılabilirliği olumsuz etkileyebilir. Modelleri yerel olarak çalıştırarak bu darboğazı ortadan kaldırabilir ve anında yanıt alma imkanı elde edebilirsiniz.

- Maliyet Etkinliği Bulut sağlayıcıları ölçeklenebilir çözümler sunsa da bunlar bir maliyetle gelir. OpenAI’nın GPT’si veya Google’ın Gemini’si gibi hizmetlere yapılan sık API çağrıları, zaman içinde önemli maliyetlere yol açabilir. Modelleri yerel olarak barındırarak, donanım ve yazılım kurulumundaki başlangıç yatırımı sonrası sürekli ücretlerden kurtulursunuz.

- Özelleştirme ve Esneklik Yerel dağıtım, model ortamı üzerinde tam kontrole sahip olmanızı sağlar. İstediğiniz gibi komutları değiştirebilir, belirli görevler için modeli ince ayarlayabilir veya özel iş akışlarınıza sorunsuz bir şekilde entegre edebilirsiniz. Bu düzeyde esneklik, özel çözümlere ihtiyaç duyan işletmeler ve araştırmacılar için paha biçilmezdir.

- Çevrimdışı Erişim İnternet bağlantısı her zaman güvenilir değildir, özellikle uzak alanlarda veya seyahat sırasında. Yerel olarak barındırılan bir AI modeli, ağ bağlantısından bağımsız olarak kesintisiz işlevsellik sağlar. Bu, AI yeteneklerine sürekli erişimin kritik olduğu senaryolar için idealdir.

- Bireysel Kullanıcıların Güçlendirilmesi AI modellerini yerel olarak barındırmak, teknoloji devlerine bağımlılığı azaltarak bireysel kullanıcıları güçlendirir. Geliştiriciler, araştırmacılar ve meraklılar artık güçlü AI araçlarından bağımsız olarak yararlanabilir. Bu, yenilikleri teşvik eder ve merkezi platformlara olan bağımlılığı azaltır.

Zorluklar ve Dikkat Edilmesi Gerekenler

AI modellerini yerel olarak çalıştırmak birçok avantaj sunarken, dikkate alınması gereken bazı zorluklar da var:

- Donanım Gereksinimleri : Yüksek performanslı GPU’lar hala pahalıdır, ancak orta seviye seçenekler daha hafif iş yükleri için giderek daha uygun hale geliyor.

- Teknik Bilgi : Yerel ortamları kurmak ve sürdürmek bir miktar teknik bilgi gerektirebilir, ancak kullanıcı dostu araçlar bu süreci basitleştiriyor.

- Model Boyutu Sınırlamaları : Çok büyük modeller hala çoğu tüketici cihazının kapasitesini aşar, bu da model boyutu veya performans üzerinde ödün verilmesini gerektirebilir.