Apple, son dönemde tanıttığı Apple Intelligence özelliklerinin arkasındaki teknolojiyi detaylandırdı ve bu süreçte NVIDIA‘nın donanım hızlandırıcıları yerine Google’ın TPU‘larını tercih ettiğini duyurdu. Şirketin resmi araştırma belgesine göre, Apple Intelligence Foundation Dil Modelleri’nin (AFM) eğitiminde Google TPU (Tensor Processing Unit) kullanılmakta.

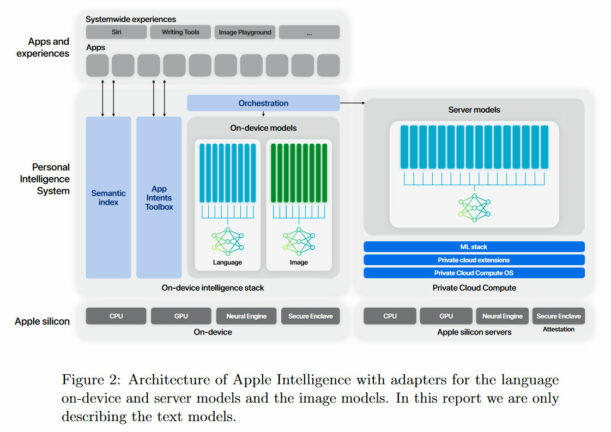

Google TPUv4 ve TPUv5 çiplerinin paketlendiği sistemler, Apple’ın AFM-server ve AFM-on-device modellerinin geliştirilmesinde önemli rol oynadı. Haziran ayında WWDC 2024‘te tanıtılan çevrimiçi ve çevrimdışı Apple Intelligenceözellikleri, bu modellerin teknolojisiyle destekleniyor.

Apple yapay zeka AFM-server, Apple’ın en büyük LLM (Large Language Model) olup sadece çevrimiçi olarak çalışmakta. Eğitim sürecinde, Applebot web tarayıcısından toplanan veriler ve çeşitli lisanslı “yüksek kaliteli” veri kümeleri kullanılmıştır. Ayrıca, seçilmiş kod, matematik ve açık veri kümeleri de eğitim verileri arasında yer aldı.

Çevrimdışı çalışan ARM-on-device modeli ise daha küçük bir yapıya sahip, ancak Apple’ın bilgi damıtma teknikleri sayesinde bu modelin performansını ve verimliliğini optimize ettiği belirtiliyor. Bu modelin eğitimi, Google TPUv5kümeleri kullanılarak yapılmış ve modelin eğitiminde 2.048 TPUv5p çipten oluşan bir dilim kullanıldığı ifade ediliyor.

Apple’ın, Apple Intelligence’a güç veren teknikleri bu kadar ayrıntılı bir şekilde paylaşması alışılmadık bir durum; genellikle teknoloji devleri bu tür bilgileri gizli tutmayı tercih eder. Şirket içi testlerde, AFM-server ve AFM-on-devicemodellerinin Talimat Takibi, Araç Kullanımı, Yazma ve diğer alanlarda üstünlük sağladığı belirtiliyor.