ABD merkezli bellek devi Micron, Nvidia’nın gelecek nesil yapay zeka çipleri için yüksek bant genişlikli HBM3e belleklerin seri üretimine başladığını duyurdu. Micron’un açıklamasına göre, Nvidia’nın yeni yapay zeka çipi H200 için özel olarak geliştirilen HBM3e bellekler, yüzde 30 daha düşük güç tüketimi ile dikkat çekiyor.

Micron’un 1β (1-beta) sürecinde üretilen 24GB 8H HBM3e bellekleri, Nvidia’nın “H200” Tensor Core GPU’larının temel bir parçası olacak ve SK Hynix’in H100 GPU’larındaki tek tedarikçi olma konumunu sonlandıracak. Micron’un yeni belleği, Nvidia H200’ün 9,2GT/s veri aktarım hızlarına ve GPU başına 1,2TB/sn’nin üzerinde bellek bant genişliğine sahip 141GB bellek kapasitesi sunacak. Bu, HBM3’e kıyasla bellek bant genişliğinde yüzde 44’lük bir artış anlamına gelmektedir.

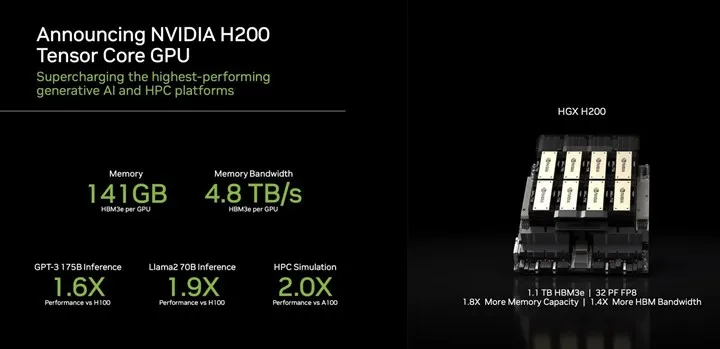

Nvidia’nın H200 ürünü, Hopper mimarisine dayanıyor ve H100 ile aynı bilgi işlem performansını sunuyor. Ayrıca, toplamda 4,8 TB/s’ye kadar bant genişliğine sahip 141 GB HBM3E bellek ile donatılarak, H100’deki 80 GB HBM3 ve 3,35 TB/s’ye kadar bant genişliğine kıyasla önemli bir iyileştirme getiriyor.

Micron’un yapay zekaya yönelik bellek yol haritası, Mart 2024’te 36 GB 12-Hi HBM3E ürününün piyasaya sürülmesiyle daha da güçlenecek. Ancak, bu alandaki rekabetin hala oldukça yüksek olduğunu belirtmek gerek. Samsung, şu anda müşterilere örneklemeye başladığı 12 istifli/katmanlı 36 GB HBM3E bellekleri ile dikkat çekiyor.